MaGe, il braccio robotico che unisce visione e linguaggio

Il progetto di TeV-Technologies of Vision per studiare l’integrazione tra linguaggio naturale, visione e robotica

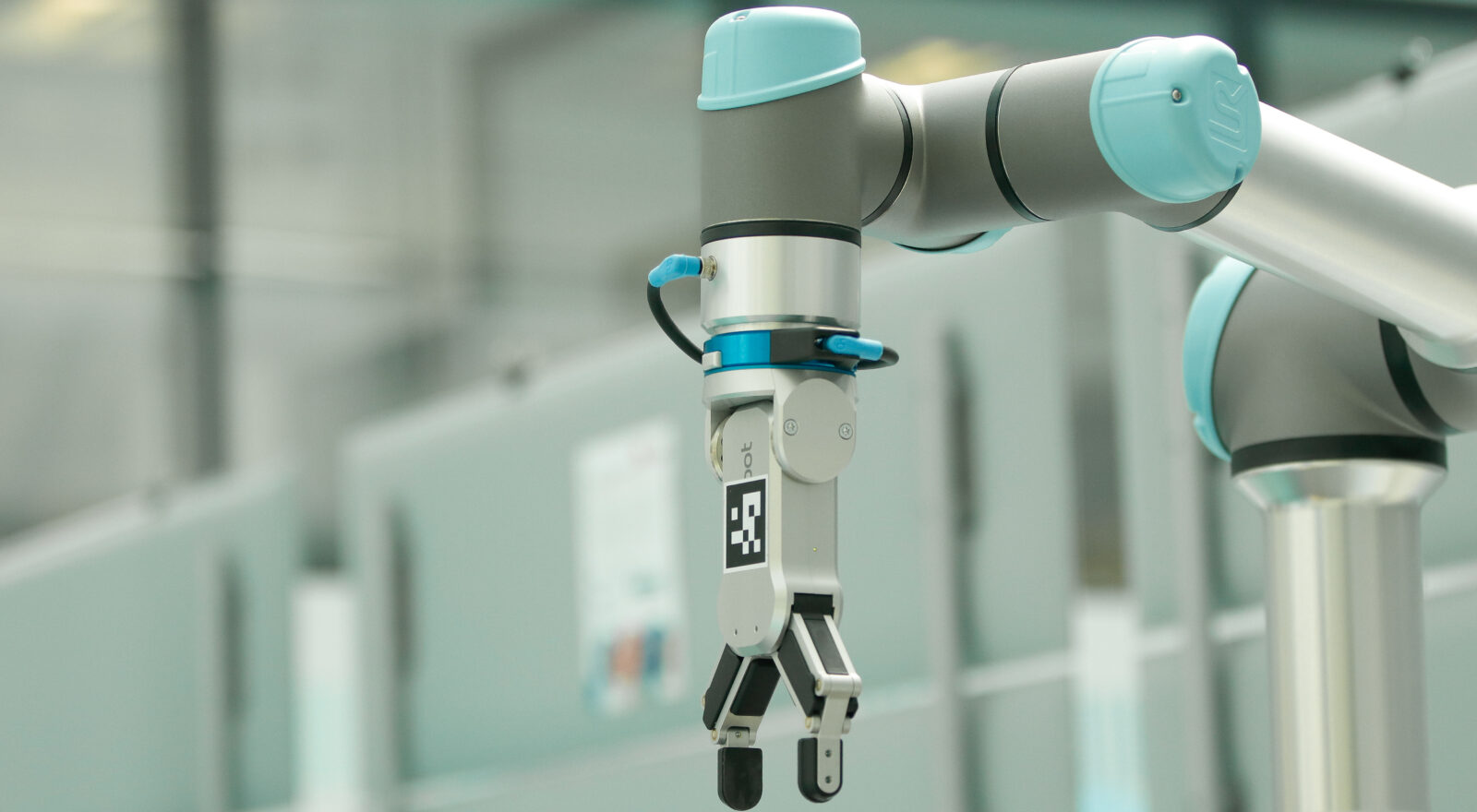

Un sistema robotico in grado di eseguire operazioni di manipolazione partendo da istruzioni espresse in linguaggio naturale: è questo l’obiettivo di MaGe – Make Grasping Easy, un progetto di ricerca condotto dall’unità Technologies of Vision (TeV) della Fondazione Bruno Kessler.

Il progetto si concentra sull’interazione tra visione artificiale tridimensionale, robotica di precisione e modelli linguistici di grandi dimensioni (Large Language Models), con l’obiettivo di migliorare l’autonomia e la flessibilità dei sistemi di grasping in ambienti non strutturati.

Partendo da una descrizione testuale e da una rappresentazione visiva della scena, il sistema è in grado di identificare gli oggetti rilevanti, stimarne la posizione nello spazio e pianificare i movimenti necessari per interagire con essi in modo sicuro. Il braccio robotico, guidato da questi dati, può così eseguire azioni di manipolazione sulla base di comandi espressi in linguaggio naturale, sia in forma scritta che vocale, elaborando in autonomia la strategia più adatta per l’afferraggio (o grasping).

“Il nostro obiettivo è studiare come il linguaggio possa diventare un mezzo efficace per controllare sistemi fisici, anche in contesti complessi,” spiega Fabio Poiesi di TeV. “L’integrazione tra comprensione semantica e percezione spaziale rappresenta una sfida aperta nella robotica”.

Tra le difficoltà affrontate, vi è la limitata capacità dei modelli linguistici attuali di gestire la dimensione spaziale. Per questo, il team sta lavorando allo sviluppo di nuovi dataset e strategie di addestramento, con l’obiettivo di migliorare la comprensione delle relazioni geometriche tra oggetti in uno spazio tridimensionale.

La componente visiva del sistema si basa su una telecamera 3D in grado di generare una nuvola di punti, da cui vengono ricavate informazioni su profondità e colore. Per garantire la precisione nella manipolazione, è stato implementato un processo di calibrazione tra il sistema di riferimento della telecamera e quello del braccio robotico, anche attraverso l’utilizzo di marker visivi.

L’output del sistema è una posa target: una combinazione di posizione e orientamento ottimale per l’afferraggio. Il braccio robotico calcola in autonomia le traiettorie necessarie per raggiungere il target, evitando collisioni con l’ambiente o con la propria struttura, grazie all’impiego di algoritmi di cinematica inversa.

Il progetto utilizza una dotazione tecnica che include una telecamera industriale ad alta precisione, in grado di rilevare dettagli con accuratezza fino a 0,2 mm, e un braccio robotico con capacità di carico fino a 5 kg e un’estensione massima di 85 cm.

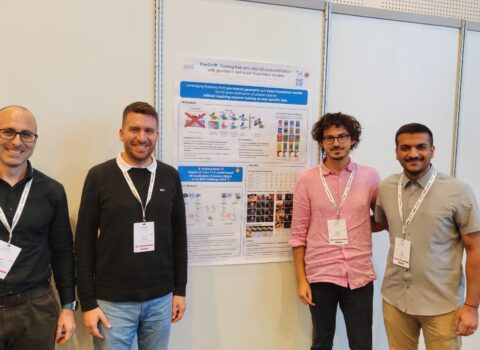

Grazie al supporto del programma VRT della Fondazione Caritro, che ha reso possibile l’acquisizione del braccio robotico, è stato costituito un team di ricerca multidisciplinare composto da Runyu Jiao, Alice Fasoli, Francesco Giuliari, Matteo Bortolon, Sergio Povoli, Yiming Wang e Fabio Poiesi, responsabile dell’unità Technologies of Vision (TeV). Questo ha rappresentato un passaggio fondamentale per l’evoluzione del progetto MaGe, consentendo sperimentazioni approfondite che hanno portato alla stesura di un articolo scientifico, che verrà presentato alla conferenza internazionale IROS (IEEE/RSJ International Conference on Intelligent Robots and Systems) questo ottobre ad Hangzhou, in Cina. Un traguardo che testimonia la qualità del lavoro svolto e il riconoscimento ottenuto a livello internazionale.

Il progetto rappresenta un esempio concreto di ricerca applicata all’intersezione tra linguaggio, visione e robotica, un’area ancora poco esplorata in Italia. L’attività dell’unità TeV si colloca in una posizione di avanguardia nello sviluppo di sistemi cognitivi robotici, con l’obiettivo di contribuire alla definizione di nuove soluzioni per l’interazione tra esseri umani e macchine, in contesti sia industriali che sperimentali.

La qualità della ricerca sviluppata dall’unità TeV trova conferma anche nei risultati ottenuti in ambito internazionale. A Novembre 2024 ha conquistato il primo posto alla BOP Benchmark for 6D Object Pose Estimation Challenge 2024, superando oltre 50 concorrenti globali, inclusi team di giganti come NVIDIA, Meta e Naver Labs. Il metodo vincente, FreeZe v2, è stato in grado di affrontare scenari complessi senza necessità di fase di addestramento, dimostrando l’efficacia dell’approccio FBK nel coniugare visione, linguaggio e robotica.

Un risultato che conferma la possibilità di competere e vincere anche partendo da contesti non metropolitani, grazie a una combinazione di talento, visione strategica e investimenti mirati. La sfida ora è trasformare questi risultati in applicazioni concrete, nella manifattura avanzata, nella robotica spaziale, nella manutenzione predittiva e molti altri campi.