La società sospesa fra un non più e un non ancora

Il rapporto fra tecnologia e società somiglia al rapporto di coppia: l’una influenza l’altra e viceversa, ma per esercitare tale condizione bisogna essere in due. Con questa chiave di lettura, attraverso l'esame di casi studio che incarnano i nodi di discussione più urgenti attorno all'innovazione, il sociologo dei media digitali Davide Bennato racconta come cambia rapidamente la nostra società e quali rischi e opportunità si presentano all'orizzonte

Esattamente trenta anni fa, nella primavera del 1994, una ricerca pubblicata sulla rivista scientifica Computer Human Interaction dai ricercatori Clifford Nass, Jonathan Steuer ed Ellen R. Tauber del Dipartimento Comunicazione dell’Università di Stanford, sanciva un nuovo paradigma sperimentale per lo studio dell’interazione uomo-computer, dimostrando che le interazioni degli individui coi computer sono fondamentalmente sociali poiché utilizziamo, inconsciamente e automaticamente, i processi sociali quando interagiamo con una tecnologia che dimostra di essere sufficientemente autorevole, autonoma o senziente. Ad esempio, nelle ricerche condotte nell’ambito Human-Robot Interaction, vediamo che i robot sono percepiti come simili agli esseri umani e che gli esseri umani interagiscono con loro a livello sociale.

Oggi, col progredire delle tecnologie intelligenti disponibili, possiamo affermare che quella teoria non è strettamente limitata ai computer, ma si estende ad altre tecnologie, come i robot e, naturalmente, l’intelligenza artificiale. In particolare, adesso che l’IA generativa comincia a entrare sistematicamente nella nostra vita quotidiana, nell’uso di alcune app specialistiche che gestiscono determinati flussi di informazione, esse saranno sempre meno tecnologie e sempre più “attori sociali”.

Abbiamo chiesto a Davide Bennato (Sociologo dei media digitali, Università di Catania) di spiegarci cosa significa e quali implicazioni comporta l’ingresso dell’IA fra gli attori sociali contemporanei.

“Siamo abituati a pensare all’IA come a un insieme di tecnologie che eseguono un determinato compito sulla base di una interlocuzione umana o di una richiesta specifica da parte di una persona o di un’altra tecnologia. Quello che però sta accadendo è che questi sistemi di IA producono un tipo di risposta informativa, sulla base della specifica richiesta, grazie a una sorta di autonomia decisionale. Questo fa sì che siano sempre meno tecnologie statiche per diventare sempre più tecnologie interattive che, come tali, hanno la proprietà di essere soggetti sociali, ossia veri e propri agenti nello spazio digitale; spazio che però è anche sociale, e nel quale pertanto questi strumenti si comportano come veri e propri “attori sociali” (come lo sono le persone, i gruppi e le organizzazioni) che svolgono attività precise di cui noi umani non abbiamo il completo controllo.

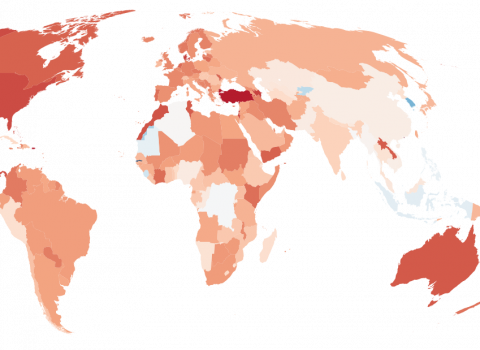

Un aspetto significativo da considerare è l’impiego di tecnologie specifiche che alimentano il fenomeno della disinformazione, il quale, a sua volta, mina le fondamenta delle democrazie. Secondo un report diffuso da NewsGuard, un servizio online specializzato nella verifica dell’affidabilità delle fonti informative tramite un team di giornalisti esperti, e da Comscore, una società specializzata nel fornire dati per il marketing digitale, emerge una situazione preoccupante all’interno di quella che potremmo definire l’industria delle fake news. Le due aziende hanno collaborato incrociando i propri database, esaminando un campione di 7.500 siti web monitorati da Comscore e 6.500 siti informativi analizzati da NewsGuard per valutarne l’affidabilità e la credibilità. Lo scopo di questa collaborazione era stimare la spesa pubblicitaria relativa ai siti web poco affidabili o responsabili della diffusione di notizie false. I risultati ottenuti gettano una luce inquietante sul fenomeno del programmatic advertising, ossia la pubblicità automatizzata basata su algoritmi di profilazione degli utenti online. Diverse ricerche convergono sui medesimi risultati, evidenziando come l’ecosistema della disinformazione sia un ambiente comunicativo tossico che sfrutta l’abilità delle notizie false nel rafforzare i pregiudizi delle persone.

- In primo luogo, emerge l’opacità degli algoritmi utilizzati. Le ricerche dimostrano come tali algoritmi siano efficaci nel raggiungere i propri obiettivi, come il targeting pubblicitario e la raccomandazione dei contenuti, ma spesso a discapito del fair use. Questi difetti di progettazione emergono solo successivamente e, una volta che il mercato si è basato su di essi, risulta costoso e quindi complesso tornare sui propri passi o riprogettarli.

- In secondo luogo, va considerato l’effetto della “bolla del filtro“. È ormai noto che la strategia di segmentazione dei contenuti in base agli interessi dell’audience tende a confinare gli utenti all’interno di una bolla che impedisce l’accesso a contenuti diversificati e altera la percezione dell’opinione pubblica circostante. Questo fenomeno crea un meccanismo di rafforzamento delle convinzioni pregresse, noto come “camere dell’eco”, che contribuisce alla radicalizzazione delle posizioni delle persone. Tale polarizzazione socio-computazionale produce un ambiente sociale e cognitivo che distorce la convivenza civile, mettendo a rischio le fondamenta delle democrazie liberali.

- In terzo luogo, è importante considerare lo sfruttamento dei bias percettivi nel consumo delle informazioni.”

Nel suo ultimo libro, afferma che mentre il XX secolo tarda a tramontare, il XXI secolo è impaziente di sorgere, in che senso?

“Da un lato, le strutture sociali – come individuo, famiglia, lavoro, media, cultura, politica ed economia che abitano questi primi decenni del 2000 – sono ancora profondamente figlie del secolo appena trascorso, e la loro persistenza è la testimonianza concreta del loro successo storico. Ma questa persistenza non vuol dire che siano ancora le strutture sociali di cui abbiamo bisogno, ma solo che la società (sineddoche per la politica) non riesce a immaginare strutture sociali alternative.

Dall’altro, le tecnologie digitali hanno spostato l’asse del potere sociale dalle élite istituzionalmente organizzate alle maggioranze tecnologicamente organizzate, dalla politica dei parlamenti alle politiche del web. È dagli anni ’90 che si parla del processo di disintermediazione (disembedding) delle istituzioni tradizionali e reintermediazione (re-embedding) attraverso nuove istituzioni sociali, e la società digitale ha rinforzato tutto questo.”

Attraverso una raccolta di casi studio esaminati sotto la lente dell’Actor Network Theory di Latour, ha mostrato più concretamente cosa intende per intreccio fra persone, dati e tecnologie, e come sia possibile intravedere il profondo cambiamento che sta delineando la natura socio-tecnica del XXI secolo.

- Il metaverso viene definito come una distopia tecnologica al servizio di una ideologia mercatista.

- Il caso “Kazakistan e bitcoin” descrive l’autonomia incontrollata delle criptovalute e le conseguenze destabilizzanti in termini di sostenibilità ambientale, economica e sociale.

- L’operazione Ironside si concentra sul ruolo delle tecnologie a supporto delle forze dell’ordine nella lotta alla criminalità internazionale.

- La socio-economia della disinformazione è presentata come strutturazione di un ecosistema produttivo e culturale tossico che comprime gli spazi di confronto democratico.

- L’impiego di TikTok nella guerra in Ucraina mostra come il livestreaming sia stato utilizzato come fonte di informazioni dal fronte.

- L’attivismo spontaneo sui social media a seguito degli attentati di Parigi del 2015 testimonia l’umanità collettiva come fenomeno emergente.

- L’allarme lanciato da Hollywood, con toni da Rivoluzione francese, a proposito dell’intelligenza artificiale, segnala la precarietà crescente nel settore e l’ascesa di sceneggiatori bot, attori sintetici e deepfake.

In tutti questi esempi emblematici, ciò che fa la differenza è lo spirito critico, ossia la nostra capacità di riconoscere “le tracce della post-realtà fra attori umani e attori non umani”, partendo dalla consapevolezza del fatto che, nel bene e nel male, “chi garantisce le regole della verificabilità sono le persone che si riconoscono in quelle regole, ovvero: è la comunità l’istituzione che garantisce le regole della verificabilità.”

Davide Bennato si occupa in particolare di sociologia digitale, consumo di contenuti online e comportamenti collettivi nelle piattaforme digitali. È autore del blog Tecnoetica.it e collabora con la testata Agendadigitale.eu. Tra le sue pubblicazioni, Dizionario mediologico della guerra in Ucraina (a cura di, con M. Farci e G. Fiorentino, Guerini 2023), La società del XXI secolo. Persone dati, tecnologie (Laterza 2024).