In dialogo col pioniere della gamification Lennart E. Nacke

In che modo l'esperienza utente può stimolare il coinvolgimento e modificare i comportamenti umani, in particolare con l’uso dell'intelligenza artificiale? Dove ci porterà l'integrazione dell'IA nei videogiochi? Il Prof. Nacke dell’Università di Waterloo (Canada) ha tenuto un seminario su questi aspetti il 9 dicembre 2025.

L’Intelligenza Artificiale (IA) sta ridefinendo il panorama di quasi ogni settore, e non fa eccezione la ricerca sugli utenti di giochi, in cui nella pratica quotidiana la comprensione sfaccettata delle esperienze di chi gioca è fondamentale.

L’IA generativa e il machine learning offrono la promessa di un’efficienza senza precedenti, riducendo i costi e i tempi. Tuttavia, l’integrazione di questi strumenti pone una sfida cruciale: come possiamo sfruttare il potenziamento dell’IA mantenendo al contempo il rigore metodologico e la qualità della ricerca?

Ospite della Fondazione Bruno Kessler, il Prof. Nacke ha affrontato questa questione nel seminario “AI Augmentation In Games User Research: How To Maintain Research Quality Using AI”, che si è tenuto il 9 dicembre presso la sede di Povo di FBK.

Il futuro della ricerca sugli utenti dei giochi

Il futuro della ricerca sugli utenti dei giochi

Riconosciuto come uno dei 10 migliori studiosi nel campo dell’interazione uomo-computer dell’ultimo decennio, il Prof. Nacke ha descritto un quadro decisionale per integrare l’IA in modo etico in tre aree di ricerca fondamentali: l’identificazione dei contesti appropriati per l’automazione, la validazione gli strumenti generati dall’IA e l’importanza di preservare il giudizio umano essenziale.

Sfide e opportunità con l’efficienza dell’IA

L’IA funge da strumento abilitante, in grado di trasformare i risultati della ricerca in applicazioni pratiche e scalabili. Nel contesto della produzione e dell’analisi di contenuti digitali, l’IA è già in grado di supportare la creatività umana fornendo punti di partenza per lo sviluppo (come nelle sceneggiature transmediali). Anche nel settore dei videogiochi, l’IA sta trasformando il game design, consentendo la generazione di mondi interattivi che si evolvono in tempo reale in base al comportamento di chi gioca. Tuttavia, pur promettendo la “democratizzazione della qualità tecnica”, l’implementazione dell’IA comporta il rischio di ridurre il processo di ricerca a una “elaborazione meccanica dei dati”, perdendo di vista una comprensione profonda delle intuizioni di chi gioca.

I tre pilastri per mantenere la qualità della ricerca

Il quadro interpretativo proposto da Nacke si concentra su tre dimensioni critiche per garantire che la ricerca sugli utenti potenziata dall’IA mantenga elevati standard di qualità:

A. Identificare contesti di automazione appropriati

L’IA non può e non deve sostituire il giudizio umano in ogni fase. È fondamentale capire dove l’automazione fallisce nel catturare le intuizioni di chi gioca. Per affrontare le sfide dell’IA, è necessario rigore scientifico, che si ottiene preservando abilità umane – quali la cultura, l’immaginazione, l’empatia, il pensiero critico e la visualizzazione – che le macchine non sono in grado di replicare.

B. Validare strumenti generati dall’IA e controllare la qualità

L’uso di strumenti generati dall’IA, dalla progettazione dei sondaggi all’analisi delle interviste, richiede una rigorosa verifica. Mantenere la qualità della ricerca e dell’innovazione è un obiettivo di grande rilevanza. La necessità di metodologie e metriche qualitative-quantitative è un tema ricorrente. In altri contesti di ricerca, i processi di valutazione che si basano fortemente sui dati quantitativi sono stati criticati per la loro inadeguatezza nel cogliere la natura complessa dell’esperienza. Pertanto, è fondamentale implementare controlli di qualità che vadano oltre la semplice misurazione meccanica per garantire che l’automazione non comprometta la validità dei risultati.

C. Preservare il giudizio umano e la trasparenza

La dimensione più critica del quadro interpretativo è la salvaguardia dell’interpretazione sfumata e dell’intuizione creativa che sono i tratti distintivi di una ricerca efficace. Ciò richiede un forte impegno in termini di etica, integrità e trasparenza. Lavorando in settori che fanno ampio uso della tecnologia dell’informazione e dell’IA, la credibilità e la protezione dei dati personali sono in primo piano, in conformità con gli standard etici e normativi come il GDPR e l’AI Act. I ricercatori devono inoltre adottare protocolli di trasparenza per documentare l’uso dell’IA.

Sono lieto di introdurre Joseph Tu, visiting scientist in FBK presso l’unità MODIS del Centro Digital Society, ricercatore in ambito Huma computer Interaction (HCI) il cui lavoro si concentra su come i segnali fisiologici possano plasmare giochi da tavolo ibridi più adattivi, coinvolgenti e accessibili. Attingendo alla sua esperienza nella progettazione di esperienza utente (UX) e nell’informatica fisiologica, esplora come rendere il gioco più inclusivo, personale e significativo.

Sono lieto di introdurre Joseph Tu, visiting scientist in FBK presso l’unità MODIS del Centro Digital Society, ricercatore in ambito Huma computer Interaction (HCI) il cui lavoro si concentra su come i segnali fisiologici possano plasmare giochi da tavolo ibridi più adattivi, coinvolgenti e accessibili. Attingendo alla sua esperienza nella progettazione di esperienza utente (UX) e nell’informatica fisiologica, esplora come rendere il gioco più inclusivo, personale e significativo.

Joseph Tu: “Con l’IA che consente la rapida generazione di contenuti e mondi procedurali, come dovrebbero evolversi le metodologie di ricerca sugli utenti per studiare esperienze che non sono più statiche ma infinitamente adattive?”

Lennart Nacke: “Ci sono diversi modi in cui posso immaginare che ciò avvenga. Ad esempio, l’adattamento metodologico e il rigore dovrebbero essere applicati agli studi longitudinali adattivi. Le nuove metodologie dovrebbero concentrarsi maggiormente sul monitoraggio longitudinale continuo per comprendere come cambiano nel tempo le esperienze dei giocatori in un ambiente adattivo, per cui abbiamo bisogno di strumenti che monitorino costantemente le azioni di chi gioca. Per chi fa ricerca, ciò significa stabilire quadri di validazione specifici per il settore, al fine di garantire un controllo di qualità che rilevi quando gli strumenti di monitoraggio automatizzati non riescono a catturare le intuizioni dei giocatori. Sarebbero necessarie soglie di prestazione e test espliciti di tutti gli strumenti di ricerca potenziati dall’IA rispetto a quelli sviluppati dagli esperti. Un ottimo flusso di lavoro in questo caso combinerebbe l’efficienza degli strumenti di IA con la profondità interpretativa e la forza delle intuizioni umane. Quindi, per quanto riguarda l’IA, essa verrebbe utilizzata per compiti descrittivi ad alta produttività, come lo sviluppo di codice per un primo primo passaggio o la sintesi delle statistiche, ma con l’obbligo di una revisione umana, in modo che gli esseri umani possano sempre aggiungere temi, sfumature o interpretazioni dipendenti dal contesto.

Gran parte di questa evoluzione consiste anche nel fatto che chi fa ricerca mantenga attivamente la propria capacità di esprimere un giudizio critico, che si può ottenere sviluppando manualmente prima i campioni di dati fondamentali o effettuando calibrazioni all’interno del team di lavoro. Quindi l’IA è sempre un co-developer, ma i team tengono un registro degli errori dell’IA in modo da individuare i punti deboli del modello che stanno utilizzando per poter co-codificare e interpretare un set di dati passo passo.

E naturalmente, come ho detto nel mio intervento, dobbiamo essere trasparenti nel documentare come utilizziamo l’IA nel processo, in modo da creare fiducia nella ricerca che stiamo conducendo con l’IA, il che ovviamente include la divulgazione esatta degli strumenti di IA che utilizziamo e in quali fasi li utilizziamo, e la conservazione di una traccia di audit con i registri delle versioni, in modo da poter tornare indietro e individuare eventuali distorsioni o anomalie nel nostro processo. Idealmente, vorremmo disporre di sistemi in grado di verificare se l’uso degli strumenti di IA nel nostro processo introduce qualche distorsione e di segnalare rapidamente eventuali modelli strani o illogici che l’IA potrebbe individuare e che gli esseri umani dovrebbero poi indagare e correggere.”

JT: “Dove ritieni che l’IA fallisca attualmente in modo più drammatico nel cogliere le sfumature delle esperienze di chi gioca?”

LN: “È una domanda molto interessante. Sulla base degli studi di cui ho parlato, penso che attualmente si possa affermare che spesso l’uso dell’IA trascura alcuni temi interpretativi e dipendenti dal contesto nei dati qualitativi e che non è molto efficace nell’ottenere la stessa profondità di comprensione degli esseri umani. Ha anche difficoltà con le sottigliezze culturali e il significato dei segnali non verbali. Cose come le pause o la cadenza delle parole pronunciate. In questo caso, un essere umano potrebbe aggiungere molte più interpretazioni di quelle che sono in grado di fornire gli attuali modelli di IA, perché questi ultimi utilizzano solo i modelli testuali per generare approfondimenti. Penso che la ricerca in generale sia contraria all’uso dell’IA in situazioni di ricerca ad alto rischio che coinvolgono pazienti traumatizzati o dinamiche di potere complesse, dove l’IA potrebbe semplicemente non essere adatta (per molte ragioni). Sulla base delle ricerche che ho letto, penso che l’IA tenda a semplificare eccessivamente le espressioni emotive soggettive e a mantenere le intuizioni piuttosto superficiali. Quindi, c’è margine di miglioramento per cogliere l’intera gamma dell’esperienza umana nel modo in cui i ricercatori e le ricercatrici possono fare quando intervistano una persona o quando osservano una sessione di gioco reale.”

JT: “Come possono i ricercatori rilevare i sottili pregiudizi introdotti dai modelli linguistici o dagli strumenti di analisi automatizzata quando studiano comunità diverse di giocatori e giocatrici?”

LN: “Credo che nell’attuale dibattito sull’aumento dell’IA e sulla ricerca sugli utenti dei giochi sia possibile individuare questi pregiudizi derivanti dagli strumenti di analisi automatizzata attraverso l’implementazione di processi di convalida sistematici e la richiesta di una supervisione umana obbligatoria basata sui risultati. Come ho già detto, i metodi chiave in questo caso sono la revisione umana, in cui i ricercatori devono effettuare una revisione delle aree in cui si sospetta che l’IA abbia interpretato erroneamente alcuni dati, e prestare attenzione a eventuali anomalie e pregiudizi che i modelli di IA potrebbero introdurre nei dati.

I ricercatori devono sempre verificare se l’IA possa essere ingiusta nei confronti di un gruppo di persone, di una cultura o di un tipo di gioco. Dobbiamo sempre essere in grado di indagare e segnalare qualsiasi modello che vediamo nei dati e abbiamo bisogno di strumenti che ci aiutino a farlo. Per stabilire una calibrazione di base per la co-codifica umana dell’IA, penso che sia importante che i codici o qualsiasi modello generato dall’IA siano sempre confrontati con quelli generati dagli esseri umani. Naturalmente, l’intero processo deve essere documentato in modo che le persone possano seguirlo o seguire i nuovi processi che vengono stabiliti qui con l’IA. Qualsiasi tipo di documentazione o registrazione dell’intero processo di ricerca e dei punti in cui l’IA viene introdotta in tale processo ci aiuterà a contrastare eventuali pregiudizi (bias) che potrebbero essere stati introdotti nell’interpretazione dei dati.”

JT: “Quali competenze ritieni che saranno necessarie alle carriere future nel campo dei giochi?”

LN: “Penso che chi farà ricerca nel campo dei videogiochi nel futuro dovrà concentrarsi maggiormente su posizioni di ricerca di livello superiore, in cui interpretare e integrare strategicamente l’IA nei flussi di lavoro. Occorrerà essere in grado di controllare e convalidare le automazioni e i sistemi di IA. Ciò include ovviamente la capacità di creare prompt chiari e ben strutturati e di iterarli per migliorare l’accuratezza dell’IA, aspetto particolarmente importante nella ricerca qualitativa. Quindi le competenze di prompt engineering sono fondamentali. Inoltre, devono essere molto bravi/e a creare argomentazioni per giustificare perché e come utilizzano l’IA per determinati compiti.

Rimarrà essenziale per la ricerca assistita dall’IA attingere al contesto in cui viene condotta la ricerca. Quindi serviranno forti competenze per formulare intuizioni e raccomandazioni finali basate su tale contesto: la cultura della comunità, il design del gioco e la situazione in cui viene giocato. Dovranno anche avere eccellenti capacità di documentazione e comprendere appieno che ogni fase del percorso potenziato dall’IA deve essere documentata e registrata, in modo da poter essere ripetutamente implementata in futuro. Servirà capire come creare sistemi, protocolli e istruzioni dettagliate, che sono fondamentali per rendere l’IA più utile. Più saranno bravi/e a scomporre un compito nelle sue sottocomponenti e nei suoi contesti, più l’IA sarà utile per loro.”

Giocare permette di vivere esperienze soggettive e oggettive impossibili nella vita reale, con sistemi di regole che consentono, a partita finita, vinta o persa che sia, di fare un passo indietro e valutare l’esperienza: un’elegante battaglia fra ingegni in cui i contendenti si sono sfidati al massimo delle loro capacità. Conferire ai giocatori obiettivi e mezzi per perseguirli apre una via, solo in apparenza semplice, a una complessità di valori che qualifica il gioco come un momento fondamentale, ed esteticamente pregnante, della vita. Il gioco ci fornisce una serie di agency che possiamo indossare in modo temporaneo e che sono una sorta di palestra per affrontare le sfide di tutti i giorni. In questo modo i giochi possono contribuire alla società, l’uso di elementi dei giochi può aiutarci a rendere la tecnologia e la partecipazione culturale più coinvolgenti. Con la diffusione sempre più capillare delle tecnologie basate sull’IA, l’abbondanza creativa non è più il problema. Il problema è che cosa ci mettiamo dentro come esseri umani, quali significati – scegliendo, creando e orientando – decidiamo di firmare con il nostro nome.

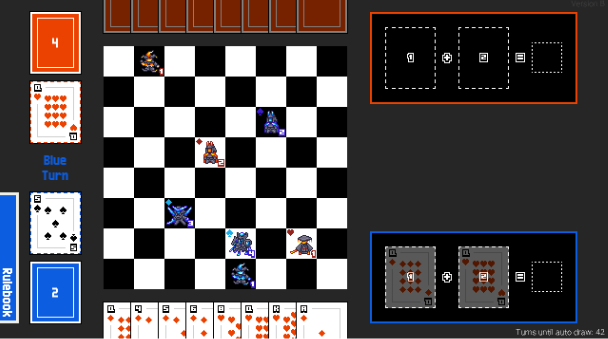

Prototipo del gioco LEVI (2023) – con Simone Bassanelli, ricercatore ospite presso The Games Institute, Università di Waterloo (Canada)

One Pulse: Treasure Hunter’s GAME (Conferenza CHI 2025) – Progettazione di giochi da tavolo con biofeedback: l’impatto della frequenza cardiaca sull’esperienza di chi gioca

Space Scavenger Squad GAME (Conferenza CHI 2025) – Da solo a sociale: esplorare le dinamiche della cooperazione tra giocatori in un exergame cooperativo co-localizzato

Joker GAME (Conferenza CHI 2025): Supportare l’autonomia: esplorare le prospettive dei giocatori sull’onboarding supportato dall’IA nei videogiochi

Dr. Lennart E. Nacke

Pioniere nel campo dei giochi, della gamification e dell’esperienza utente. In qualità di titolare della cattedra di ricerca universitaria e professore di Interazione Uomo-Computer (HCI) nei giochi presso l’Università di Waterloo, esplora come l’esperienza utente dei videogiochi e dei giochi di esercizio fisico possa stimolare il coinvolgimento e modificare i comportamenti, in particolare utilizzando l’intelligenza artificiale. Negli ultimi 15 anni ha pubblicato più di 200 articoli accademici e un libro best-seller sulla ricerca sugli utenti dei giochi. Richiestissimo come relatore principale, il Dr. Nacke ha fornito consulenza a organizzazioni di tutto il mondo su strategie di gamification efficaci e sull’uso dell’intelligenza artificiale. È stato riconosciuto tra i 10 migliori studiosi di HCI dell’ultimo decennio e tra il 2% dei migliori scienziati a livello mondiale. Il suo lavoro innovativo continua a plasmare il modo in cui comprendiamo e applichiamo la ricerca sull’intelligenza artificiale, l’esperienza utente e i giochi. https://lennartnacke.com/

Joseph Tu

In qualità di ricercatore HCI, esplora come i segnali fisiologici possano consentire esperienze di gioco da tavolo ibride accessibili, adattive e immersive. La sua ricerca integra il calcolo fisiologico, la progettazione UX e l’accessibilità per sviluppare esperienze di gioco divertenti, personalizzate e inclusive. Curiosità: ha iniziato il suo percorso di ricerca attraverso sculture cinetiche interattive che utilizzavano suoni e movimenti, una pratica artistica che ancora oggi influenza il suo approccio alla progettazione di esperienze di gioco accoglienti ed emotivamente coinvolgenti.